Comment nos préjugés deviennent un problème éthique pour une intelligence artificielle ?

IA et biais (1/3) - L'humain, une source du problème.

Written by Stéphanie Lehuger

Thinker et entrepreneuse

Comment nos préjugés deviennent un problème éthique pour une intelligence artificielle ?

Pourquoi les biais posent des problèmes éthiques en intelligence artificielle ?

Nous avons tous des biais

Imaginez que vous faîtes vos courses avec une personne aveugle. Vous arrivez devant un rayon de bananes et la personne vous demande ce que vous voyez. Qu’allez-vous lui décrire ? Il y a des bananes ? Il y a des bananes avec de petits autocollants dessus ? Il y a environ 30 bananes ? Il y a peu de chances pour que vous disiez qu’il y a des bananes qui sont de couleur jaune. Le jaune est une information typique pour une banane et on a tendance à ne pas mentionner les évidences. C'est une forme de biais, ou d'angle mort cognitif. Et nous avons tous des biais cognitifs, c’est humain.

Pourquoi les biais d’une IA sont un problème ?

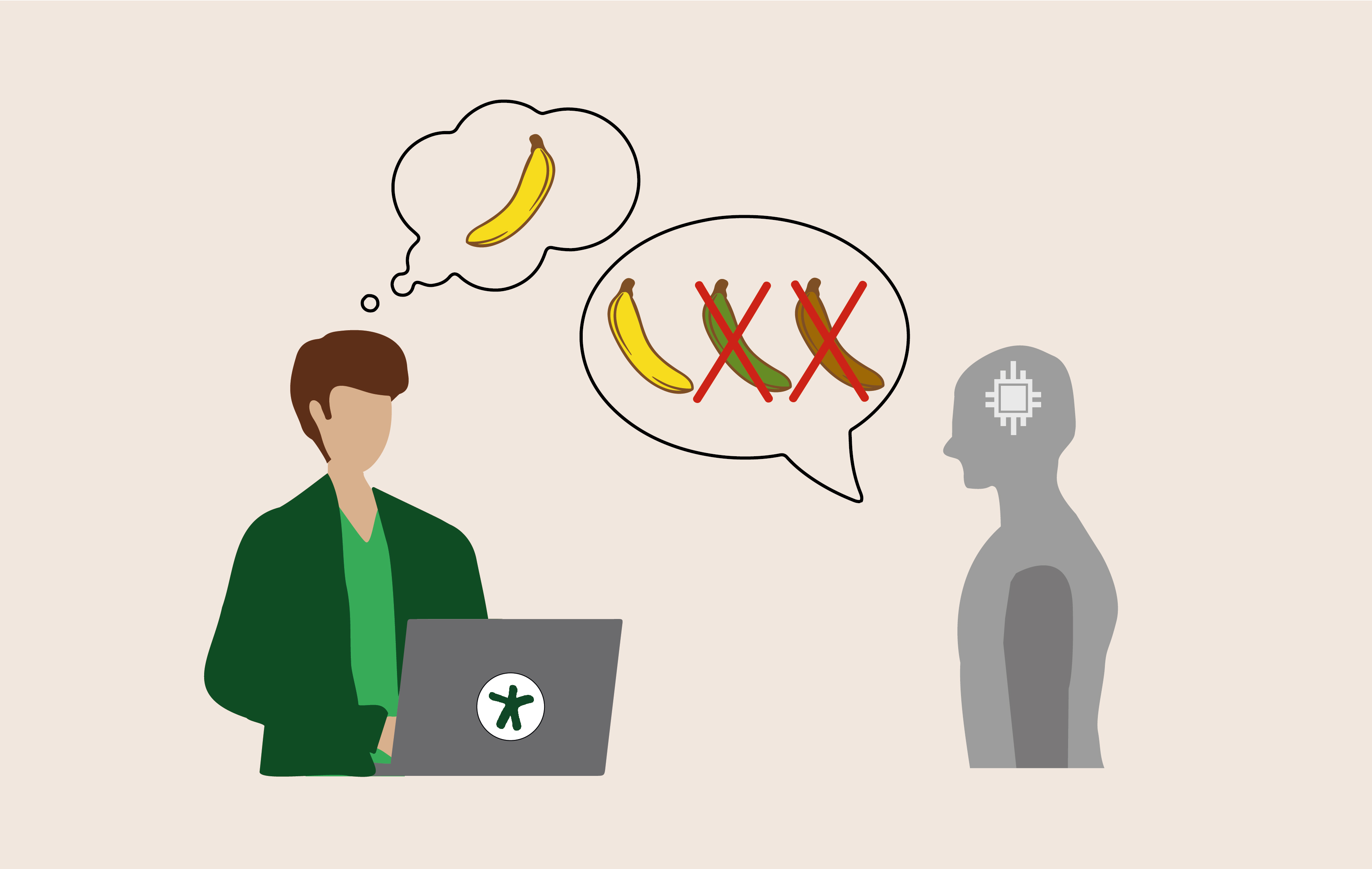

Nos biais humains sont un problème quand on les transmet à une intelligence artificielle. C’est un problème aussi bien éthique qu’en termes de performance du logiciel basé sur ces biais. Concrètement, en utilisant la technique de l’apprentissage machine, on va entraîner l’intelligence artificielle à reconnaître des bananes en lui montrant des images de bananes. Si toutes les images que je lui montre sont des bananes jaunes, le jour où l’intelligence artificielle va voir une banane verte, elle ne va pas penser que c’est une banane. Il y a des chances qu’elle l’associe plutôt à une autre chose verte qu’elle a déjà vue, comme un concombre par exemple.

Éthiquement, c’est un problème. Parce que, quand on parle de bananes, cela paraît anodin. Mais cela peut parfois conduire à des conséquences graves. En effet, même un humain bienveillant a des préjugés inconscients. Parfois, sans s’en rendre compte, des data scientists peuvent transmettre leurs biais au travers des données qu’ils sélectionnent pour construire des logiciels. Prenons l’exemple d’un système de vidéosurveillance automatisée utilisé par la police. La Chine est friande de ces systèmes prédictifs pour interpeler des suspects, comme l’a dénoncé Human Rights Watch concernant l’usage du système de surveillance de masse IJOP (Integrated Joint Operation Platform). Imaginons de manière caricaturale que le logiciel a appris à reconnaître des personnes à partir d’un jeu de données composé à 90% de portraits d'hommes à la peau blanche. L’algorithme n’étant pas entraîné à reconnaître des femmes à la peau noire, il sera alors complètement inefficace sur cette population et pourrait mener à des erreurs judiciaires s’il était utilisé. Ainsi, le logiciel de prédiction des récidives COMPAS utilisé par des juges américains pour les assister dans leur verdict a surestimé systématiquement le risque de récidive des détenus afro-américains tandis que celui des blancs a été très sous-estimé.

Un algorithme fonctionne comme une recette de cuisine : avec des ingrédients, les données, et une recette, le code. Même si c’est la partie la plus visible, la réussite de la recette ne dépend pas tant du code que de la qualité des ingrédients utilisés, les données. S’ils sont de mauvaise qualité, quelle que soit la recette, le succès ne pourra pas être au rendez-vous. Les résultats des algorithmes ne dépendent donc pas que de la manière dont les programmeurs les ont écrits. Les biais ont des origines diverses. Les biais d'acquisition de données par exemple sont liés à la manière dont les données sont collectées. Par exemple, si on estime la moyenne mensuelle de clients d’un hôtel dans une station de ski en se basant uniquement sur les chiffres des mois d’hiver, on va surestimer le résultat. Le contexte est essentiel dans l’acquisition de données parce que, si la période de l'année à laquelle on collecte des données n'est pas représentative de l'année entière, le résultat sera faussé. Nos biais représentent un problème quand ils entraînent des conséquences discriminatoires mais ils sont le plus souvent positifs. En effet, dans le cas normal, nos biais sont aussi ce qui nous permet d'avancer et de prendre des décisions rapides en environnement inconnu, transmettant ainsi des informations bénéfiques aux algorithmes.

C’est donc à la fois un problème éthique et un problème de performance des algorithmes. Imaginons que la police décide du quartier où elle patrouille sur les suggestions d’une intelligence artificielle. Si le logiciel dispose de l’historique d’actes de délinquance de deux quartiers, l‘un avec un petit peu plus de délinquance que l’autre, il va orienter les policiers vers le quartier où il y en a eu un peu plus dans le passé. En arrivant dans ce quartier, si les policiers constatent une infraction, ils vont approvisionner la base d’apprentissage de nouvelles données. Alors que, s’ils avaient été dans l’autre quartier, ils auraient peut-être aussi constaté une infraction. Mais maintenant, l’intelligence artificielle est biaisée parce qu’elle considère que ce quartier connaît plus de délinquance. Avec ce biais, les algorithmes peuvent ainsi former ce qu’on appelle des “boucles de rétroaction” par lesquelles stéréotypes, discriminations et inégalités se renforcent mutuellement, contribuant ainsi à cristalliser durablement des situations d’inégalité. En plus de ne pas être performante, l’intelligence artificielle n’est alors pas non plus éthique. C’est ainsi qu’un audit critique du logiciel de police prédictive de la ville de Los Angeles, PredPol, a amené à abandonner son usage.

Personne n’est à l’abri de risques éthiques

Les médias rapportent les cas les plus sensationnalistes, comme celui d’Amazon par exemple. Un programme informatique discriminait les femmes à l'embauche parce que les informations sur lesquelles l'intelligence artificielle avait basé son apprentissage étaient des effectifs historiquement masculins de développeurs informatiques.

Il existe un risque pour les professionnels qui créent des intelligences artificielles de se sentir éloignés de ces sujets sensationnalistes et, ne se sentant pas concernés, de ne pas faire attention aux biais dans leur travail. Par exemple, les équipes de Twitter qui ont travaillé sur l’algorithme qui choisit quelle partie d’une photo s’affiche en aperçu sur Twitter n’ont pas bien contrôlé les biais dans leur travail. Leur logiciel recadrait simplement l’image d’un utilisateur pour donner un aperçu pertinent de l'image. Pourtant, les utilisateurs ont remarqué que, sur une photo avec plusieurs personnes, ce recadrage se focalisait plus sur les personnes blanches que les personnes noires. En effet, quand on se base sur les images présentes sur internet, les personnes blanches sont en moyenne plus mises en avant que les personnes noires.

Il est donc recommandé à toute personne travaillant sur une intelligence artificielle de toujours s’interroger sur les biais possibles qu’elle est susceptible d’y introduire, aussi peu risqué que le projet puisse paraître.

La solution proposée par la Commission européenne aux problèmes d’éthique de l’IA

Aujourd’hui, une des rares entités qui régule l’éthique est la Commission européenne avec une proposition de loi qui réglemente l’intelligence artificielle. A l’instar de la mise en œuvre du règlement général sur la protection des données (RGPD), de nombreuses entreprises se plaignent que la Commission européenne complique la vie des ingénieurs parce qu’elle ne comprend pas les implications techniques de ce qu’elle ordonne. Du point de vue du citoyen toutefois, la réglementation protège la vie privée mieux qu’avant. D’autant que, ces dernières années, minimiser le risque d'un bad buzz lié à une violation de la vie privée est peut-être devenu plus important pour les sociétés que les contraintes techniques que le RGPD engendre et a été le catalyseur de bonnes pratiques pour éviter ce type de risque.

Le travail de datacraft

Des membres du Club datacraft se sont réunis tout au long de l'année 2021 pour apporter des réponses concrètes sur les questions d’IA éthique. C’est ainsi qu’ils ont abouti à la rédaction d’une charte pour formaliser les fondements d’une IA de confiance et mettre un accent particulier sur sa dimension éthique. Un groupe de data scientists issus d’entreprises (Antoine Isnardy de Danone, Théo Alves Da Costa d’Ekimetrics...), de labos de recherche (Nathan Noiry de Télécom Paris, Eliot Moll de l’Inria...), ou freelances en résidence datacraft (Yann Girard d’HephIA...) a aussi travaillé sur la cartographie des outils open source du marché pour limiter les biais dans les modèles d’intelligence artificielle (tels que, entre autres, les biais sociaux comme les biais sur le genre, l’âge…).

Il est toujours possible d'apporter votre contribution à ce travail en rejoignant datacraft !